Обзор и отзывы на проект «Алгоритм Королёва. «Королёв»: действие алгоритма на практических примерах Как работает алгоритм королева

Что он анализирует не только заголовок страницы, но и весь контент страницы прежде, чем показать пользователю результаты запроса.

Прошла всего неделя, еще рано делать выводы, но, тем не менее, мы спросили у представителей seo-сообщества об их ожиданиях от нового алгоритма и изменениях в работе seo-мастеров.

Кирилл Николаев, технический директор студии "ВЭБЛАБ" :

Сразу после выхода Палеха был понятен дальнейший вектор развития нового алгоритма. Перед самым анонсом были жаркие споры, что же будет (самый популярный вариант: первая страница - онли директ), но в глубине души мы все понимали, чего ждать. Яндекс увеличил цифры, и это не может не радовать. Если раньше в оперативке висело 150 документов по популярным запросам, то теперь их число перевалило за 200 000, чему очень усердно помогают спецагенты из Толоки. Чтобы быть в топе этих 200 000, нужно иметь хорошие поведенческие (что логично) и схожую семантику, что заставляет думать о том, что времена воровства контента возвращаются с новой силой. И времена длинных простыней в каталогах интренет-магазинов тоже говорят нам "Привет, Андрей!".

Однако, насколько мне известно, матрица для популярных запросов хранится в базе на время действия очередного апдейта, в то время как матрица для НЧ/МНЧ запросов формируется на лету.

Ожидать того, что в выдаче произойдут такие колоссальные изменения, как после запуска Снежинска в 2009 году, не стоит, так что ВЧ/СЧ запросы мы оставим в покое и поговорим про более приземлённые вещи.

Лично меня больше всего заинтересовало вот это заявление:

"...новый алгоритм не только сравнивает текст веб-страницы с поисковым запросом, но и обращает внимание на другие запросы, по которым люди приходят на эту страницу". Для отрасли это может означать две вещи:

1. Хорошая: ещё более тщательный подбор семантики, ещё более усердная кластеризация дадут свои плоды. Текстовые факторы выходят в лидеры по важности и актуальности, работать становится сложнее, но результат становится лучше.

2. Плохая: максимальный объём текста для индексации одного документа - 32 тысячи символов. Так что могу ожидать, что теперь под описанием каталога в каком-нибудь магазине можно будет читать небольшие новеллы про доставку воды, в которых есть завязка, развитие, кульминация, развязка и эпилог. Это логично, потому что это самый простой метод расширить семантику. Я, конечно, утрирую, ибо понятно, что ТОП формируется несколько иначе, но очень подозреваю, что наши "короли контента" воспримут это именно так.

Ну и вдобавок просто накину мысль: если не переписывать тексты и не тратить время на сложные вещи, а пытаться грамотно накрутить трафик по НЧ/МНЧ-запросам? Интересное поле для экспериментов.

Яндекс развивается и мы растём вместе с ним.

Это здорово. Хочется много представлять, каким он будет через 5-10-15 лет.

Хочешь быть хорошим сеошником - учи матчасть.

Это прекрасно. Жду с нетерпением новых курсов от БМ на тему "Семантические векторы для бизнеса". А если серьёзно - профессия становится сложнее, что не может не радовать. Надеюсь, что совсем скоро исчезнут индивидуальности, которые делают ссылочные прогоны по базам, составленным по "последним исследованиям Дмитрия Шахова (известного SEO-практика)".

Ещё большее погружение в текстовые факторы

Больше, чем курсы от БМ, я жду только запуск нейросетевого подбора семантики и кластеризации от Чекушина. И курс от Деваки, конечно.

Алаев Александр, директор веб-студии «АлаичЪ и Ко» :

Яндекс выкатил новый алгоритм с большим шумом и волнением. Я думал, что моя жизнь, как оптимизатора изменится бесповоротно, но… спешу всех успокоить – ничего не изменилось!

Новый алгоритм Яндекса направлен на улучшение выдачи по «длинным» информационным запросам (такие запросы характерны для голосового поиска). Яндекс со своей нейросетью начал понимать и искать по смыслу, то есть не только по ключевым словам, но и по тому, что они означают. Продолжение «Палеха», который искал смыслы только по заголовкам документов, «Королев» ищет смыслы по всему документу. Но это вы и так знаете, если смотрели презентацию или читали публикации по ее мотивам.

Давайте же о том, как это повлияет на жизнь веб-мастеров и оптимизаторов. Повторюсь – никак. Никак новый алгоритм не коснется коммерческих запросов. Если человек что-то хочет купить или заказать, то уж наверняка знает, что именно. А даже если и не знает, то все равно, подразумевая ноутбук, не будет спрашивать «компактный настольный компьютер состоящий из двух половин», а сначала выяснит, как эта штука называется.

Королев должен положительно отреагировать на качественные информационные страницы. А вот генерированные, синонимизированные и тому подобные тексты должны потерять в трафике, если вообще его имели. Думаю, что рерайт и копирайт, написанный без погружения в тематику, также могу пострадать, уступив место более качественным текстам, пусть и без употребления нужных ключевых слов в нужных количествах.

Как видите, ничего нового я не сказал, а сайты, как и раньше, надо делать качественными и для людей!

Александр Ожигбесов, руководитель проекта ozhgibesov.net :

Введением новых алгоритмов в поиск Яндекс мелкими, но уверенными шагами идет в сторону понимания смысла запроса и поиска такого же осмысленного ответа - это то, как преподносят нам Палех и Королев в компании. На деле же это копия алгоритма Google - Колибри (Hummingbird), который был запущен в 13 году, однако, стоит реально оценивать доступные мощности компании. Яндекс не может завтра же дать ответы на все уникальные запросы и перестроить выдачу. Ошибка в компании в том, что они преподнесли алгоритм, как нечто новое, хотя в Гугле сделали это раньше и без подобного "русского" пафоса, но это безусловно сильное достижение и я уверен, что в будущем нейросети смогут показать нам идеальный поиск, если к тому времени отечественный поисковик не сделает всю первую страницу выдачу платной. Но это тоже не особо страшно, перераспределим приоритеты и будем масштабировать семантику для контекста.

Какие изменения ждут оптимизаторов и будут ли они вообще?

Особых изменений после Палеха и Королева в данный момент в популярном ecommerce нет. Пока Яндекс обкатывает свои алгоритмы на МНЧ, ожидать резких изменений в регламентах и методиках компаний не приходится. Здесь сеошникам беспокоиться особо незачем, длинные и уникальные запросы присутствуют только в инфо-тематиках и сложных коммерческих услугах. Но ведь задача Палеха и Королева не заменить текущие параметры ранжирования, они пытаются дать осмысленные ответы на сложные запросы, поэтому подбирать запросы вида "Красное платье, через которое видно трусики" совсем необязательно. Лично моё мнение - я топил и буду топить за качественное написание и структуризация контента, последующую аналитику и дооптимизацию, поэтому алгоритм не нанесет урона на серьезные коммерческие проекты, как это было, например, с Минусинском.

Здравствуйте, дорогие читатели блога сайт. Прошу прощения, что некоторые посты выходят с большим промежутком по времени, но я запустил еще несколько проектов, которые резко вырвались в ТОП за 1,5 месяца, используя свои знания в области блоггинга (кому нужна консультация пишите в личку). Приходится разрываться между проектами и стройкой дома для своей семьи.

Сегодня затронем новый алгоритм Королев от Яндекса и постараемся сравнить его с предшественниками. Лично на мой блог, он особо не повлиял, разве что полезные и объемные статьи стали еще выше в ТОПе. Ну давайте подробнее рассмотрим все в статье и сделаем необходимые выводы после наблюдения за этим алгоритмом.

Алгоритм Королёв Яндекс - что это такое и как работает

В конце августа 2017 вышел новый алгоритм Королев Яндекс. Новость об обновлении в поисковике сразу же заинтересовала СЕО специалистов и СМИ.

Главная особенность Королева является увеличение скорости обработки информации и повышение качества смыслового анализа текста.

В несколько тысяч раз повысилась скорость обработки данных. Палех для формирования ТОПа использовал 150 документов. Теперь сравнивается более 200 000 статей между собой. Этот результат был достигнут за счет оптимизации протокола ранжирования.

Чтобы понять новый алгоритм, надо вернуться на шаг назад к Палеху. Его презентация проведена 2 ноября 2016 года. Статистика показывала, что наибольшая часть поисковых фраз приходится на НЧ фразы, заточенные под единственно верный ответ. Эта часть приходится на длинный хвост птицы.

Чтобы дать нужный ответ клиенту необходимо обладать ассоциативным мышлением и навыком самообучения, как у человека. С подобными задачами лучше всего справляются нейронные сети, поэтому они и стали основой нового алгоритма.

Главная цель «Королёва»

При желании найти конкретный предмет человек начинает описывать его свойства, это особенности ассоциативного мышления. Если мы забыли название видео, то мы начинаем говорить, что содержалось внутри: «фильм про девушек во время войны» или «фильм про существо с хвостом и крыльями». В первом случае Яндекс предоставляет «А зори здесь тихие», во втором варианте получаем «химера».

Яндекс улучшает качество сравнения многословных фраз. Программа анализирует связь между каждым, словом в предложении и выстраивает своеобразную ассоциацию с множеством вариантов ответов. Также как это делает человеческий мозг.

Что нового?

Нововведения:

- семантический вектор для всего контента, а не только заголовка;

- сравнение более 200 000 статей при формировании поисковой выдачи;

- учитывается поведение пользователя на странице;

- люди помогают обучать систему.

Королев анализирует не только заголовок, а полностью весь контент (в том числе фото, видео, таблицы и т. п.) и на его основе составляет семантический вектор.

Главным нововведением стало многократное ускорение работы поисковых методов. В прошлом семантический вектор выстраивался в момент введения фразы в поисковую строку. Подобный метод сильно нагружал сервера и задерживал скорость выдачи ответа.

При отправке поисковой фразы происходит сравнение его семантического вектора с массивом уже записанных в базе данных. Палех сравнивал около 150 вариантов, новая же версия анализирует более 200 000 статей за 1 раз. За счет чего повышается шанс нахождения желаемого ответа.

Нейросеть Яндекс: принцип работы нейронной сети Королев + примеры

Главной особенностью нейронной сети является возможность самообучения. Работа осуществляется не только по преднамеренным формулам, а также на основе предыдущего опыта и ошибок.

Человеческий мозг представляет собой огромнейшую нейросетьс ассоциативным мышлением, компьютеры же стараются эмитировать человеческое поведение за счет воссоздания архитектуры нейронных сетей.

Особенности нейросетевой структуры

Нейронная сеть представляет из себя множество единичных нейронов, каждый из которых хранит или обрабатывает информацию. Каждый из нейронов способен принимать, обрабатывать и отдавать сигналы. Поток входных данных постепенно перерабатывается от одного нейрона к другому и в конце получается необходимый результат.

Искусственные нейронные сети передают между собой условные веса – числа от 0 до 1, чтобы определить насколько тот или иной вариант входящей информации соответствует нужной информации. После окончания анализа нейрон с наибольшим весом считается наиболее подходящим для ответа на поставленный вопрос.

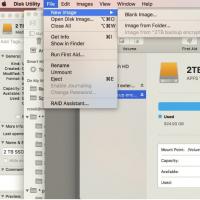

Схема изображает нейронную сеть. Первые два слоя занимаются обработкой. Каждый из нейронов содержит определенную функцию, которая получает входные данные и после обработки выдает необходимый ответ. Так сравниваются семантические вектора.

Семантические векторы

Компьютеры не умеют оперировать словами или картинками, поэтому для сравнения информации между собой они используют массивы чисел. Поисковики должны самостоятельно определять главную тему и мысль текста, чтобы выдавать пользователю то что ему нужно.

Чем схоже вектора заданного вопроса и текста, тем выше находится статья в приоритете выдачи. В Королеве используется анализ всего контента:

- таблицы;

- текст;

- фото;

- видео;

- заголовки;

- цитаты;

- списки;

- выделения (курсив, жирный и т. д.).

В несколько раз повышается качество построения вектора за счет преобразования большего количества информации.

Для создания векторов используется нейросеть, текст пропускают через последовательность нейронов и в итоге получают выходной трехсотмерный массив из чисел. В дальнейшем его вносят в единую базу данных и используют для сравнения.

Обучение

Главная особенность нейронных сетей – обучаемость. В отличие от стандартных алгоритмов нейроны способны запоминать свой предыдущий опыт и самообучаться на нем. Компьютер с каждым разом все лучше и лучше различает информацию.

В прошлом обучением занимались сотрудники компании, их задача состояла переходить по миллионам запросов и на свое усмотрение изменять приоритеты выдачи. Затем разработчики создали приложение Яндекс.Толока, оно представляет из себя список несложных заданий. Надо переходить по запросам и оценивать качество поисковой выдачи. За каждое задание платят около 0.1-1$

Какой контент по мнению нового поискового алгоритма является хорошим

Наиболее подходящей для ТОП выдачи будет статья содержащия максимум полезной информации для пользователя и соответствующая запросу. Следовательно, в ней должны по разделам раскрываться всевозможные вопросы клиента.

В Королеве в приоритете учитывается поведение пользователя на странице. Поэтому задача администраторов постараться удержать пользователя и заинтересовать его. Чтобы это сделать используйте структурированность заголовков, таблицы, списки, выделения, фото и видео.

Новые приоритеты поиска

SEO специалисты, после релиза, провели исследование, чтобы оценить изменения приоритетов ранжирования. Особых изменений не наблюдалась приоритетами остаются:

- структурированность текста;

- полнота раскрытия темы;

- простата чтения контента;

- соответствие заголовков смысловому содержанию текста;

- правильное формирование семантического ядра.

Главное писать для живых людей, этот приоритет остается самым важным.

Зачем Яндекс запустил новый поисковый алгоритм и чем это грозит сайтам

Любая компания стремится сделать свою продукцию лучшей на рынке услуг. В данном случае крупнейшим соперником Yandexявляется Google. Нововведения были созданы для следующих целей:

- улучшение качества поиска по нестандартным вопросам;

- привлечение новых инвесторов;

- увеличение продуктивности ранжирования (более 200000 статей при формировании выдачи).

Главная цель была улучшить качество выдачи. Кроме того, надо было показать инвесторам, что работа в компании ведется полным ходом и их деньги использовались по назначению.Новшества в последующем использовались при создании голосового помощника «Алиса».

Линейка предыдущих алгоритмов

Чтобы лучше разобраться с новыми технологиями надо вернуться в прошлое. В данном случае рассмотрим линейку предыдущих алгоритмов, которые использовались поисковиком для ранжирования.

В первое время интернет содержал всего пару тысяч сайтов, чтобы найти нужную статью на них достаточно было сравнить ключевые слова поисковой фразы. В последующем глобальная сеть разрасталась в геометрической прогрессии, сейчас на одну тематику можно найти более сотен тысяч схожих сайтов с миллионом статей.

Поэтому надо было усложнить системы ранжирования и начали учитывать следующие дополнительные параметры:

- количество ссылающихся материалов;

- уникальность контента;

- поведение клиента на странице.

Матрикснет

В 2009 году Yandex столкнулись с проблемой, что статьи все чаще не отвечают на вопросы пользователей. Чтобы исправить эту ошибку надо было научить сервера самостоятельно принимать решения и самообучаться.

Была изобретена сложная математическая формула с множеством параметров для определения соответствия текста к поисковой фразе.

Но оставались следующие проблемы:

- поиск зависит от слов;

- не учитываются вспомогательные материалы (фото, видео, цитаты и т. п.).

Главная из проблем была в том, что не всегда в одном заголовке можно было полностью описать смысл статьи. Довольно часто в статье нет конкретных ключевых слов, но при этом она полностью раскрывает тему и дает развернутый ответ на вопрос пользователя.

Алгоритм Палех

В 2016 году в системе ранжирования была применена компьютерная модель нейросети. Главная особенность подобного подхода в том, что теперь компьютер способен запоминать свои ошибки и обучаться на собственном опыте.

В этом же году были введены семантические вектора. Название статьи пропускалось через нейронную сеть и раскладывался на множество векторов. Теперь компьютеры сравнивали не слова из поиска, а многомерные массивы чисел и векторов. Удалось уйти от прямой зависимости от количества тех или иных слов в фразе, а отдать приоритет смысловому содержанию.

Из недочетов осталась проблема низкой скорости работы. Для формирования поисковой выдачи сравнивались всего 200 наиболее подходящих статей. Поэтому системе было сложно отыскать многословные смысловые фразы типа «фильм про девочку, шпионку которая сбегает и учиться в школе».

Алгоритм Yandex Королев

В последнем нововведении в первую очередь провели оптимизацию нейросети и улучшили продуктивность обработки текста. Сейчас вектора сравниваются заранее в оффлайн режиме, благодаря этому удалось повысить результативность формирования поиска.

Yandex самостоятельно собирает статистику об заинтересованности пользователей и по ним создает заранее подготовленную поисковую выдачу.

Благодаря оптимизации семантический вектор составляется не только для заголовков, а для всего контента целиков. Удается найти максимум смысловых связей между словами.

Угрозы для сайтов

В целом никаких опасностей для сайтов не создалось и статистика переходов особо не изменяется. В первую очередь нововведения коснуться информационных блогов, форумов и сайтов с фильмами.

С лидирующих позиций могут слететь вебсайты не отвечающих интересам пользователя. Например, название «домашний яблочный сок», а в статье рассматриваются методы выращивания деревьев, блинчики с повидлом и совершенно иной текст.

Не забываем сделать репост и подписаться на рассылку блога. Всех благ.

Всего наилучшего, Галиуин Руслан.

1. Пользователи

С точки зрения пользователей, бывает странно, что одинаковые по смыслу, но отличающиеся по написанию запросы выдают разные результаты. Многие пользователи задают запросы в поисковую систему так, как будто спрашивают у друга. Новому алгоритму отвечать на эти запросы будет проще.

2. Вебмастера

В идеальном мире вебмастера должны делать хорошие продукты, создавать качественный контент и не думать о том, чтобы специально продвигать свой сайт в поисковых системах. В реальности им часто приходится подстраивать тексты и сам сайт под поисковики.

3. SEO-специалисты

Часть методов, которые помогали продвигать сайты раньше (например, SEO-копирайтинг) уже не дадут такого эффекта. Конечно, будут попытки обхитрить и новый алгоритм, но часть сил будет направлена на создание качественного контента.

Пока судить о качестве нового алгоритма рано, но чем больше ответов он даст, тем лучше он станет. Поэтому в перспективе пользователи должны почувствовать разницу.

Что это за машинка?

С внедрением и ростом уровня IQ нейросетей в поисковых системах будет в геометрической прогрессии расти качество и релевантность выдаваемого контента. Машинка умеет анализировать визуальный контент, понимает смысл слов и выражений.

Попытка вплетать в страницы любые популярные инфоповоды, не имеющие прямого смыслового отношения к тематике ниши ресурса, будет приводить к исключению из выдачи.

Преимущества

Ключевое преимущество нейросети не в том что она умеет анализировать, а в том что она умеет учиться и запоминать. То есть ресурсы, которые по выбору пользователей не будут соответствовать ожиданиям выдачи, будут также постепенно выпадать из выдачи.

То есть машинка фиксирует, что на запрос А релевантное количество пользователей всегда кликает на ресурс Б и никогда не кликает, на ресурс Г. Ресурс Г будет исключен из ниши соответствия запросу А.

Поживем несколько недель – увидим

С одной стороны, название не такое еб***тое, как «Палех». И это уже хорошо. С другой стороны, все еще не успели в совершенстве адаптироваться под «Палех», как вот тебе новый более закрученный алгоритм, который все больше фокусируется на контенте.

Content is a king – подтверждается после каждого апдейта

Из плюсов очевидно, что это дает все большую возможность прогрессивным смекалистым и новым площадкам побороться в насыщенных нишах с уже давно состоявшимися лидерами выдачи, а также отправляя все в более далекий астрал бездумных SEO-копирайтеров, которые делали на сайтах помойку из перечисления анкоров в текстах.

Алгоритм дает возможность нового профессионального роста копирайтерам с головой , они могут заняться чем-то более полезным, чем писать посты для соцсеточек.

Но, со скептической точки зрения, вряд ли «Яндекс» упустит момент, чтобы продвинуть свои коммерческие возможности и их необходимость, в частности контекст.

Такие новости я всегда воспринимаю очень позитивно. Так как помимо SEO-оптимизации у тебя возникает большая площадь для контент-стратегических действий, а это выводит SEO на новый уровень. К нему перестают относиться как к чему-то странному и непонятному. В привычном людям виде SEO - нае****во, раньше так и было, но время идет, а устаревшее восприятие осталось.

Логика такая: раньше на рынке было много вебстудий, которые делали SEO, а кто-то просто делал вид, что делал, но брал на это бюджет. Вторых преобладало в количестве. Вот почему сложилось мнение, что SEO - лохотрон. Время идет, каждый апдейт алгоритма вытесняет тех, кто «делал вид», а устаревшее восприятие людей до сих пор осталось.

Новый алгоритм «Королев» логично продолжает изменения в поиске «Яндекса» в последние годы. Больший упор на нейросети, анализ всего содержания страницы, а не только заголовков.

Очень важный момент - анализ других поисковых запросов, по которым пользователи попадают на текущую страницу, что позволяет точнее определять релевантность контента и взаимосвязь поисковых запросов между собой.

Резюмирую: качество поиска повысится. И это здорово.

До свидания, SEO-тексты

Интересно, как новый алгоритм покажет себя в реальной жизни. Нужно время, чтобы оценить и адекватность смысловой выдачи, и приоритеты ранжирования.

Однозначно теперь поиск должен будет лучше справляться с нестандартными и редкими запросами, если сеть действительно видит больший смысл за ключевыми словами. Очень на это надеюсь, потому что это еще один шаг к «До свидания, SEO-тексты». Однако при этом сеть надо будет обучать. Это, похоже, не шутка.

Я только что попробовала запрос «Фильм мальчик со шрамом на лбу» и получила в выдаче много отсылок на фильм «Лицо со шрамом». То есть ключевые слова все-таки пока побеждают смысл.

И только если я найду в выдаче нужные мне страницы с Гарри Поттером, проведу на них значительное количество времени, машина поймет, какой смысл я вкладывала в запрос, и уточнит выдачу к следующему разу. По крайней мере, так должно быть. Процесс обучения быстрым не будет, но в любом случае это хороший шаг в будущее.

Если чуть ближе к бизнесу...

Сегодня на запрос «Шкаф с отъезжающей дверцей купить» упорно получаю духовые шкафы и кучу ненужного (жалюзийные, распашные и так далее).

Суть алгоритма - на этапе индексации URL определять дополнительные свойства документа, выразив в численном виде соответствие текста страницы заранее известным и часто употребимым словосочетаниям. Заявлено, что нововведение коснется низкочастотных запросов, которые составляют около трети от результатов поиска.

Из-за отсутствия статистики по таким «редким» запросам, качество поиска по ним страдает. Фактически этот алгоритм будет вытаскивать из небытия документы, которые не содержат длинный запрос в прямом виде, но являются близкими по смыслу к запросу пользователя.

Для маркетологов и SEO-специалистов важно, что их оптимизированные сайты будут конкурировать не только друг с другом, но также и с сайтами, которых вообще не касалась рука оптимизатора.

Конечно, это касается только низкочастотных запросов и оценка доли запросов как 1/3 от потока - это оценка сверху. Но в ближайшее время некоторые сайты могут столкнуться с оттоком низкочастотного трафика. При этом любые численные прогнозы пока делать бессмысленно.

На мой взгляд, сама по себе идея построения различных индексов, составленных из размеченных н-грамм (а именно об этом заявляет «Яндекс» ), лежит на поверхности. Например, одной из главных фич краулера statoperator является построение индекса по н-граммам.

Н-граммы более информативны, чем отдельные слова, поддаются классификации и позволяют существенно расширить количество факторов для построения поиска по смыслу. Я рад, что «Яндекс» идет в правильном направлении и на высоком уровне внедряет актуальные методы, позволяющие повысить скорость и качество поиска.

Мнение Дмитрия Севальнева, руководителя департамента SEO и рекламы в «

«Королёв» – это алгоритм поисковой системы Яндекс, на котором основана новая версия поиска. Запущен в августе 2017 года. Является логическим продолжением алгоритма «Палех». Нейронная сеть, обучаемая по поисковой статистике, поведению пользователей, сопоставляет смысл, суть запроса и веб-страниц, что позволяет лучше отвечать на сложные запросы.

Принцип работы

Поисковый алгоритм «Королёв», в отличие от созданного ранее «Палеха», анализирует не только тайтл, а всю страницу целиком. Определение смысла проходит одновременно с индексацией, что существенно увеличивает скорость и количество обрабатываемых страниц.

Чтобы пользователь получал ответ, используются несколько этапов. На каждом из них документы упорядочиваются, лучшие проходят в следующую стадию. С повышением уровня применяются все более тяжелые алгоритмы.

Чтобы ускорить финальную стадию и увеличить объем анализируемых документов, был введен дополнительный индекс, содержащий вычисленную на этапе индексирования примерную релевантность для популярных слов и их пар из запросов пользователей. Это позволило значительно увеличить глубину – до 200 тыс. документов на запрос.

Кроме сравнения заданного вопроса со смыслом страницы, алгоритм учитывает, по каким еще запросам пользователи просматривали конкретный документ, что позволяет устанавливать дополнительные смысловые связи.

Алгоритм использует нейронную сеть, которая обучается на обезличенной статистике. Для обучения нейросети привлекаются простые пользователи. Если раньше этим занимались только сотрудники Яндекса, асессоры, то сейчас любой может принять участие в обучении строящего формулу ранжирования методу машинного обучения «Матрикснет», выполняя задания в Яндекс.Толоке.

«Королёв» затрагивает многословные запросы с уточнением смысла, а это, как правило, информационные, низко- и микрочастотные, часто заданные голосовым поиском. В качестве ответа могут быть страницы, где вообще отсутствуют некоторые употребленные в запросе слова.

Сразу после запуска по многим уточняющим запросам справа от выдачи пользователям предлагалось оценить качество ответа на вопрос, указать сайт, который был более удачным.

Влияние на SEO

Наибольшее влияние поисковый алгоритм «Королёв» оказывает на информационные запросы со сложной, многословной, часто уникальной формулировкой. Однако замечено, что сайтам с вхождениями каких-то слов из запроса все-таки часто отводятся более высокие позиции.

На выдачу по типовым коммерческим запросам алгоритм «Королёв» пока практически не оказывает влияния. Однако все большее обращение Яндекса в сторону понимания смысла закономерно наводит на мысль, что это вопрос времени. Поэтому:

- нужно уделять больше внимания информативности контента, его ценности и полезности для пользователя, не лить воду;

- эра «тошноты» текста, точных вхождений ключевых фраз уходит в прошлое;

- использование принципов LSI-копирайтинга с тематикозадающими словами, синонимами и т. д. перспективнее традиционного вписывания ключевых слов и где-то может привлечь дополнительный трафик;

- нужно уделять пристальное внимание семантической разметке, чтобы помочь Яндексу правильно понять контент страниц;

- важно поддерживать высокие показатели поведенческих факторов (время посещения, глубину просмотра и т. д.).

«Космическая» премьера Яндекса – не только смена структуры индекса, но и своего рода очередное напоминание, что нужно делать контент для людей, а не только для попыток манипулировать выдачей.

22 августа 2017 Яндекс запустил новую версию поискового алгоритма – «Королёв». Максимально кратко и емко можно описать его суть словами из пресс-релиза Яндекса:

Запуск алгоритма состоялся в Московском планетарии и сопровождался докладами разработчиков алгоритма, торжественным нажатием кнопки запуска и даже звонком на МКС и прямым эфиром с космонавтами.

Полное видео презентации можно посмотреть прямо здесь, а ниже мы рассмотрим основные изменения и ответы на частые вопросы. Информацию мы будем сопровождать комментариями сотрудников Яндекса в блоге компании, а также цитатами из официальных источников.

Что изменилось в поиске Яндекса?

«Королев» – это продолжение алгоритма «Палех », представленного в ноябре 2016 года. «Палех» был первым шагом в сторону семантического поиска, задача которого – лучше понимать смысл страниц.

«Королев» же теперь умеет понимать смысл всей страницы, а не только заголовка title, как было после анонса «Палеха».

Алгоритм должен улучшить выдачу по редким и сложным запросам.

Документы могут не содержать многих слов запроса, поэтому традиционные алгоритмы определения текстовой релевантности не справятся с этой задачей.

Выглядит это примерно так:

В Google работает аналогичный алгоритм – RankBrain:

Область действия алгоритма «Королев» распространяется на все запросы, в том числе на коммерческие. Однако больше всего влияние заметно именно на многословных запросах. Яндекс подтвердил, что алгоритм работает на всем поиске.

Конечно, целью алгоритма было улучшение качества выдачи по редким и сложным вопросам. Проверим на редких и сложных коммерческих запросах, связанных как раз с названием предмета.Например, в этом случае Яндекс действительно понимает, о чем идет речь. Правда, в выдаче в основном обзоры и статьи, а не коммерческие сайты.

А в этом случае поисковик понял, что меня, скорее всего, интересует дрон или квадрокоптер. Конечно же, выдача начинается с Яндекс.Маркет:

Но в некоторых случаях Яндекс бессилен…

Как это работает (+ 11 фото из презентации)

Разберем подробнее презентацию нового алгоритма. Ниже будут только выдержки самых интересных моментов с нашими комментариями и слайды из презентации.

Новая версия поиска основана на нейронной сети. Она состоит из большого количества нейронов. У нейрона есть один выход и несколько входов, он умеет суммировать полученную информацию и после преобразования передавать ее дальше.

Нейронная сеть может выполнять гораздо более сложные задачи и ее можно обучить понимать смысл текста. Для этого нужно дать ей много обучающих примеров.

Работу в этом направлении Яндекс начал с модели DSSM, состоящей из двух частей, соответствующих запросу и странице. На выходе была оценка, насколько они близки по смыслу.

Для обучения нейросети нужно много обучающих примеров.

Отрицательные – это пара текстов, не связанных по смыслу.

Положительные – пары «текст-запрос», связанные по смыслу.

Согласно презентации, Яндекс использовал для обучения массив данных о поведении пользователей на выдаче и считал связанными по смыслу запрос и страницу, на которую часто кликают пользователи в выдаче. Но как позже пояснил Михаил Сливинский, удовлетворенность пользователя результатами поиска меряются не только кликами:

Как ранее рассказывал в презентации "Палеха" Александр Садовский, наличие клика не говорит о том, что документ релевантен, а отсутствие, что не релевантен. Модель Яндекса предсказывает, задержится ли пользователь на сайте и учитывает множество других метрик удовлетворенности пользователя.

После обучения модель представляет текст в виде набора 300 чисел – семантического вектора. Чем ближе тексты по смыслу, тем больше сходство чисел векторов.

В поиске Яндекса нейронные модели использовались давно, но в алгоритме «Королёв» увеличено влияние нейронных сетей на ранжирование.

Теперь при оценке смысловой близости алгоритм смотрит не только на заголовок, но и на текст страницы.

Параллельно Яндекс работал над алгоритмом сравнения смыслов запросов на основании нейронных сетей. Например, если для одного запроса поисковая система точно знает лучший ответ, а пользователь ввел запрос, очень близкий к нему, тогда результаты поиска должны быть похожи. В качестве иллюстрации такого подхода Яндекс приводит пример: «ленивая кошка из монголии» – «манул». ()

В «Палехе» нейронные модели применялись только на самых поздних стадиях ранжирования, приблизительно на 150 лучших документов. Поэтому на ранних стадиях ранжирования часть документов терялась, а они могли быть хорошими. Это особенно важно для сложных и низкочастотных запросов.

Теперь вместо вычисления семантического вектора во время исполнения запроса Яндекс делает вычисления заранее – при индексации. «Королёв» проводит вычисления на 200 тыс. документов на запрос, вместо 150, которые были раньше при «Палехе». Сначала такой метод предварительного расчета был испытан на «Палехе», это позволило сэкономить на мощности и находить соответствие запросу не только заголовка, но и текста.

Поисковик берет полный текст на этапе индексации, проводит нужные операции и получает значение. В итоге для всех слов и популярных пар слов формируется дополнительный индекс со списком страниц и их предварительной релевантностью запросу.

Команда Яндекса, которая занималась проектированием и внедрением нового поиска, запускает его.

Запуск алгоритма:

Обучение искусственного интеллекта

В Яндексе уже много лет задачей сбора данных для машинного обучения занимаются асессоры, которые оценивают релевантность документов запросу. С 2009 по 2013 год поисковик получил более 30 млн таких оценок.

За это время появился поиск по картинкам, по видео, внутренние классификаторы и алгоритмы: количество проектов Яндекса выросло.

Так как все они работали на технологиях машинного обучения, требовалось больше оценок и больше асессоров. Когда асессоров стало больше 1500, Яндекс запустил краудсорсинговую платформу «Толока» , где может зарегистрироваться и выполнять задания любой человек.

Например, вот такие задания встречаются в «Толоке»:

Или такие:

Если хотите подробнее узнать, как пользователи оценивают релевантность ответов, чтобы понимать, какие параметры выдачи оцениваются, рекомендуем почитать инструкции по заданиям или даже попробовать пройти обучение.

За несколько лет в сервисе собралось более 1 млн человек, которые сделали более 2 млрд оценок. Это позволило Яндексу сделать огромный рывок в масштабировании и объеме обучающих данных. Только в 2017 году задания выполняли более 500 000 человек.

Среди заданий есть:

- Оценка релевантности документов;

- Задания для развития карт. Так проверяют актуальность данных об организациях для базы Справочника;

Задания для настройки речевых технологий голосового поиска.

Правила, которым Яндекс хочет научить алгоритм, открыты всем зарегистрированным пользователям в виде инструкций для работников «Толоки». По некоторым заданиям просто собирается субъективное мнение людей.

Вот выдержка из инструкции о том, как Яндекс определяет релевантность документа:

Яндексу очень важно качество оценок. Оно может быть субъективно, поэтому задания даются сразу нескольким людям, а потом математическая модель оценивает распределение голосов с учетом степени доверия к каждому работнику и экспертизы каждого участника. Для каждого «толокера» хранятся данные о точности оценок по каждому проекту и сводятся в единый рейтинг.

Именно поэтому нельзя сетовать на то, что необъективность асессоров погубила ваш сайт.

Таким образом, в Яндексе появилась дополнительная группа факторов:

- Смысл страницы и соответствие ее запросу;

- Является ли документ хорошим ответом на похожие пользовательские запросы.

Что изменилось в топе Яндекса?

Алгоритм предположительно был запущен несколько раньше презентации и, если верить сторонним сервисам (например, https://tools.pixelplus.ru/updates/yandex), изменения в выдаче начались еще в начале августа, но неизвестно, связано ли это с алгоритмом «Королев».

По этим данным можно выдвинуть гипотезу, что уменьшение доли главных страниц в топ-100 и уменьшение возраста документов в пределах топ-100 связано с новым алгоритмом, который помогает получить больше релевантных ответов.

Правда, при этом заметных изменений в топ-10, топ-20 или топ-50 не видно. Возможно, их там нет либо они незначительны. Мы также не заметили существенных изменений выдачи по продвигаемым запросам.

Текстовая релевантность в стандартном понимании никуда не делась. Подборки и более широкие ответы по многословным запросам содержат большое количество страниц с вхождениями слов запроса в title и текст:

Свежесть результатов поиска тоже имеет значение. Пример из презентации Яндекса содержит ряд свежих результатов с искомой фразой целиком.

Хотя, учитывая тот факт, что алгоритм проводит расчеты сразу при индексации, «Королев» теоретически может влиять и на подмешивание результатов быстроботом.

Надо ли как-то оптимизировать тексты под «Королев»?

Скорее наоборот: чем больше поисковик учится определять смысл текста, тем меньше требуется вхождений ключевых слов и тем больше требуется смысла. Но принципы оптимизации не меняются.

Например, еще в 2015 году Google рассказал об алгоритме RankBrain, который помогает поиску лучше отвечать на многословные запросы, заданные на естественном языке. Он неплохо работает, что отметили пользователи в многочисленных публикациях сравнения поиска Яндекса и Google после анонса новой версии алгоритма.

Это не сопровождалось масштабной презентацией и сильно не повлияло на работу специалистов. Никто целенаправленно не занимается «оптимизацией под RankBrain», поэтому и в Яндексе это никак глобально не меняет работу специалиста. Да, появился тренд на поиск и включение в текст так называемых LSI-ключей, но это явно не просто часто повторяющиеся слова на страницах конкурентов. Ожидаем развития SEO-сервисов в этом направлении.

В алгоритме также заявлено, что анализируется смысл и других запросов, по которым пользователи попадают на страницу. Опять же, в перспективе это должно дать одинаковую или похожую выдачу по синонимичным запросам, так как сейчас результат анализа выдачи порой показывает, что пересечений по синонимичным запросам в выдаче нет. Будем надеяться, что алгоритм поможет устранить подобные несоответствия.

Но Яндекс пока не может найти (или плохо находит) документы, близкие по смыслу к запросу, но вовсе не содержащие слов запроса ().

Советы:

Убедитесь, что страница отвечает на запросы, под которые она оптимизирована и по которым переходят пользователи.

Убедитесь, что страница все же включает слова из поисковых запросов. Мы не говорим про прямые вхождения, просто проверьте, есть ли слова из запросов в любой форме на странице.

Тематические слова могут придать странице дополнительную релевантность, но это явно не просто часто повторяющиеся слова на страницах конкурентов. Ожидаем развития SEO-сервисов в этом направлении.

Для ключевых фраз, по которым страница сайта хорошо ищется, проверьте, не выбивается ли показатель отказов из среднего показателя по сайту. Если по запросу сайт находится на высокой позиции и пользователь находит то, что ему нужно, сайт может быть показан по сходным по смыслу ключевым фразам (если такие есть).

Клики на поиске показывают удовлетворенность пользователя результатом. Это не ново, но стоит еще раз проверить сниппеты по ключевым запросам. Возможно, где-то получится повысить кликабельность.

Как проверить влияние алгоритма на свой сайт?

Для сайтов, у которых нет ярко выраженной сезонности, вы можете сравнить количество низкочастотных ключевых фраз, по которым переходили на сайт до запуска алгоритма и после. Например, взять неделю в июле и неделю в августе.

Выбираем «Отчеты – Стандартные отчеты – Источники – Поисковые запросы».

Выбираем визиты из Яндекса:

И фильтром оставляем только те запросы, по которым был 1 переход. Дополнительно стоит исключить фразы, содержащие название бренда.

Также можете посмотреть наличие поисковых фраз, слов из которых у вас нет в тексте. В целом, такие фразы присутствовали среди НЧ-запросов и раньше, просто сейчас их может стать заметно больше.

Перспективы и прогноз

Поисковик сможет еще лучше находить документы, близкие по смыслу к запросу. Наличие вхождений станет еще менее важным.

К текущему алгоритму будет добавлена персонализация.

В перспективе хорошие материалы, отвечающие на вопрос пользователя, могут получить еще больше трафика по микрочастотным, редким или семантически похожим запросам.

По низкочастотным ключевым фразам может увеличиться конкуренция за счет большей релевантности неоптимизированных документов.

Гипотеза. С помощью подобных алгоритмов Яндекс может лучше оценивать, насколько семантически связаны страницы, ссылающиеся на другие, и учитывать это для оценки внешних ссылок. Если это может быть значимым фактором с учетом слабого влияния ссылок в Яндексе.

Нам стоит ожидать дальнейших изменений, связанных с нейросетями, и в других сервисах Яндекса.

Вопрос-ответ

Вопрос : так как Яндекс оценивает клики, значит ли это, что накрутка поведенческих факторов будет набирать обороты?

Вопрос : связан ли «Королев» с «Баден-Баденом»?

Вопрос : как включить новый поиск Яндекса?

Ответ : в блоге Яндекса и в поисковых запросах часто встречались вопросы, как включить или установить новый поиск. Никак . Новый алгоритм уже работает и никаких дополнительных настроек делать не нужно.